Rozdíl mezi Hadoopem a SQL

Obrovská data generovaná každou sekundu prostřednictvím sociálních médií, jako je Facebook, Twitter, Instagram, vydláždila cestu pro rozvoj Hadoop / Big Data Ekosystému. Termín „3V“, který odkazuje na Volume, Velocity a Veracity, definuje význam Hadoopu pro zpracování datových proudů. Dnes jsou data generována z více zdrojů, které je třeba integrovat pro různé účely, jako je Reporting, Data Analysis a Research, a pro centralizované ukládání dat. Když tak děláme, vznikají četné problémy s tradičními přístupy, jako je prostor, přístup, integrita, struktura a šířka pásma. Pro řešení všech těchto problémů poskytuje Hadoop rámec, který umožňuje zpracovávat data s obrovskou velikostí, poskytuje snadný přístup, vysokou dostupnost a dynamicky načítá data. Má strukturu distribuovaného systému souborů (HDFS) pro ukládání dat a vestavěného dotazovacího procesoru nazvaného „Map Reduce“ pro analýzu a zpracování dat uložených v HDFS.

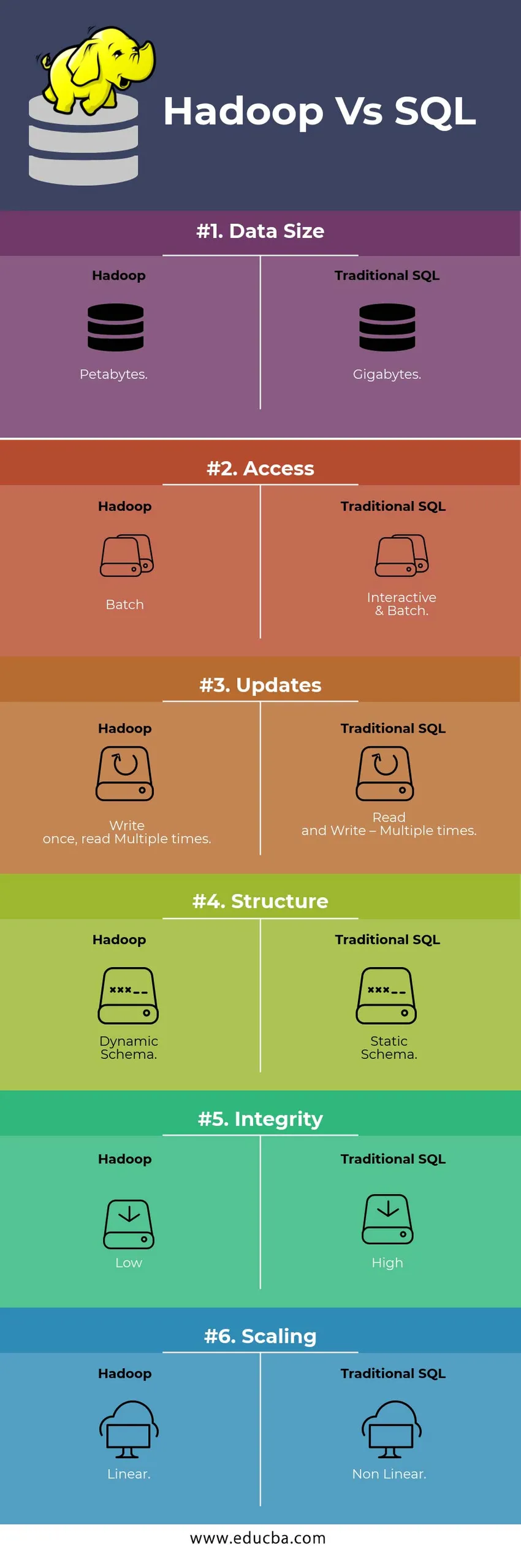

HEAD TO HEAD Porovnání mezi Hadoop Vs SQL

Níže je uveden Top 6 Rozdíl mezi Hadoop Vs SQL

Klíčové rozdíly mezi Hadoop Vs SQL

Níže je rozdíl mezi Hadoop a SQL následující

- Schéma na WRITE Vs READ

Obecně v tradiční databázi, během načítání / migrace dat z jedné databáze do druhé, následuje schéma přístupu Write. Díky tomu je proces načítání dat vzrušený / přerušený a má za následek odmítnutí záznamů kvůli rozdílu ve struktuře zdrojových a cílových tabulek, zatímco v systému Hadoop - všechna data jsou uložena v HDFS a data jsou centralizována.

Hadoop framework se používá hlavně pro proces Data Analytics. Podporuje tedy všechny tři kategorie dat, tj. Strukturovaná, polostrukturovaná a nestrukturovaná data a umožňuje schéma přístupu ke čtení.

- Strukturovaná data mají určitý formát. g .: XML soubor.

- Data Semi Structures jsou volnější; Může mít / nemá schéma. g .: Tabulka

- Nestrukturovaná data nemají specifickou strukturu ani schéma. Např .: Prostý text nebo obrázek.

Hadoop pracuje efektivně s nestrukturovanými daty, protože má schopnost interpretovat data během doby zpracování.

| Přístup | Výhoda | Výhoda Dis |

| Schéma při zápisu | · Předdefinované struktury

· Rychlejší čtení. Např .: Tradiční RDBMS. | Pomalé načítání dat

Vysoká latence |

| Schéma čtení | · Dynamická struktura

· Rychlé psaní a čtení. Např .: Hadoop | Rychlé načítání dat

Nízká latence |

Tabulka : Schéma na schématu WRITE VS na ČTENÍ.

- ROZHODNOST A NÁKLADY

Hadoop Framework je navržen pro zpracování velkého objemu dat. Kdykoli se velikost dat zvětší, lze do clusteru přidat velmi snadno více dalších zdrojů, jako je datový uzel, než tradiční přibližování přidělování statické paměti. Čas a rozpočet je pro jejich implementaci relativně méně a společnost Hadoop také poskytuje Data Locationity, kde jsou data zpřístupněna v uzlu, který úlohu provedl.

- ODOLNOST PROTI CHYBÁM

V tradičním RDBMS, kdy jsou data ztracena v důsledku poškození nebo jakéhokoli problému se sítí, trvá více času, nákladů a zdrojů, než se ztracená data vrátí. Hadoop má však mechanismus, ve kterém data mají minimálně tři úrovně replikačního faktoru pro data uložená v HDFS. Pokud dojde k selhání některého z datových uzlů, které uchovávají data, lze data snadno získat z jiných datových uzlů s vysokou dostupností dat. Díky tomu jsou data snadno dostupná uživateli bez ohledu na jakékoli selhání.

- FUNKCIONÁLNÍ PROGRAMOVÁNÍ

Hadoop podporuje psaní funkčního programování v jazycích jako java, scala a python. Pro každou aplikaci, která vyžaduje jakékoli další funkce, lze implementovat registraci funkcí definovaných UDF v HDFS. V RDBMS není možné psát UDF, což zvyšuje složitost psaní SQL. Data uložená v HDFS jsou navíc přístupná všem ekosystémům Hadoop, jako je Hive, Pig, Sqoop a HBase. Pokud je tedy UDF napsán, může být použit kteroukoli z výše uvedených aplikací. Zvyšuje výkon a podporu systému.

- OPTIMALIZACE

Hadoop ukládá data v HDFS a Process ačkoli Map Reduce s obrovskými optimalizačními technikami. Nejoblíbenějšími technikami používanými pro manipulaci s daty jsou rozdělení a ukládání uložených dat do oddílů. Dělení je přístup k ukládání dat v HDFS rozdělením dat na základě sloupce uvedeného pro rozdělení. Když jsou data vložena nebo načtena do systému HDFS, identifikuje sloupec oddílu a vloží data do příslušného adresáře oddílu. Dotaz tedy vyvolá sadu výsledků přímým načtením dat z rozděleného adresáře. To redukuje skenování celé tabulky, zlepšuje dobu odezvy a zabraňuje latenci.

Jiný přístup se nazývá Bucketing dat. To umožňuje analytikům snadno distribuovat data mezi datovými uzly. Všechny uzly budou mít stejný počet distribuovaných dat. Sloupec bucketing je vybrán takovým způsobem, aby měl nejméně kardinalitu.

Tyto přístupy nejsou k dispozici v tradiční metodě SQL.

- DATOVÝ TYP

V tradičním přístupu jsou podporované datové typy velmi omezené. Podporuje pouze strukturovaná data. Čištění a formátování schématu dat tedy zabere více času. Hadoop ale podporuje komplexní datový typ, jako je Array, Struct a Map. To podporuje použití různých druhů datových souborů, které se mají použít pro načtení dat. Například: XML data lze načíst definováním dat s prvky XML obsahujícími komplexní datový typ.

- KOMPRESE DAT

Pro tradiční databázový systém je k dispozici velmi méně vestavěných kompresních technik. Ale pro Hadoop framework existuje mnoho kompresních technik jako gzib, bzip2, LZO a snappy. Výchozí kompresní režim je LZ4. Dokonce i tabulky lze komprimovat pomocí kompresních technik, jako je Parquet, ORC. Techniky komprese napomáhají tomu, aby tabulky zabíraly velmi méně místa, zvyšují propustnost a rychlejší provádění dotazů.

Srovnávací tabulka Hadoop Vs SQL

| Vlastnosti | Tradiční SQL | Hadoop |

| Velikost dat | Gigabajty | Petabytes |

| Přístup | Interaktivní a šarže | Dávka |

| Aktualizace | Čtení a zápis - vícekrát | Napište jednou, přečtěte vícekrát |

| Struktura | Statické schéma | Dynamické schéma |

| Integrita | Vysoký | Nízký |

| Měřítko | Nelineární | Lineární |

Tabulka : Porovnání tradičních Hadoop a SQL Framework.

Závěr - Hadoop Vs SQL

Hadoop celkově předstihuje tradiční SQL, pokud jde o náklady, čas, výkon, spolehlivost, podporu a dostupnost dat pro velmi velkou skupinu uživatelů. Aby bylo možné efektivně zpracovat obrovské množství dat generovaných každý den, framework Hadoop pomáhá včasně zachytávat, ukládat, zpracovávat, filtrovat a nakonec v něm ukládat na centralizovaném místě.

Doporučený článek

- Hadoop vs Hive - Zjistěte nejlepší rozdíly

- Naučte se 10 užitečných rozdílů mezi Hadoopem a Redshiftem

- HADOOP vs RDBMS | Poznejte 12 užitečných rozdílů

- Apache Hadoop vs Apache Spark | Top 10 srovnání, které musíte znát!

- Hadoop vs Spark: Funkce