Přehled Install Hadoop

Následující článek, Instalovat Hadoop poskytuje přehled nejběžnějších modulů klíčových modulů Hadoop a postupnou instalaci pro Hadoop. Apache Hadoop je kolekce softwaru, která umožňuje zpracování velkých datových sad a distribuovaného úložiště v klastru různých typů počítačového systému. V současné době zůstává Hadoop nejpoužívanější analytickou platformou pro velká data („Sanchita Lobo, autor na Analytics Training Blog“, nd).

Hadoop Framework

Rámec Apache Hadoop se skládá z následujících klíčových modulů.

- Apache Hadoop Common.

- Distribuovaný systém souborů Apache Hadoop (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (ještě jiný správce zdrojů).

Apache Hadoop Common

Modul Apache Hadoop Common se skládá ze sdílených knihoven, které jsou spotřebovány ve všech ostatních modulech, včetně správy klíčů, obecných I / O balíčků, knihoven pro sběr metrik a utilit pro registr, zabezpečení a streamování.

HDFS

HDFS je založen na souborovém systému Google a je strukturován tak, aby fungoval na levném hardwaru. HDFS toleruje chyby a je určen pro aplikace, které mají velké soubory dat.

MapReduce

MapReduce je inherentní paralelní programovací model pro zpracování dat a Hadoop může spouštět MapReduce programy psané v různých jazycích, jako je Java. MapReduce funguje tak, že rozdělí zpracování do fáze mapy a zkrátí fázi.

Apache Hadoop YARN

Apache Hadoop YARN je základní komponentou a je technologií správy zdrojů a plánování úloh v distribuovaném procesním rámci Hadoop.

V tomto článku se budeme zabývat instalací a konfigurací Hadoop 2.7.4 v jednom uzlu clusteru a otestujeme konfiguraci spuštěním programu MapReduce s názvem wordcount, aby se spočítal počet slov v souboru. Dále se podíváme na několik důležitých příkazů systému souborů Hadoop.

Kroky k instalaci Hadoop

Následuje přehled úkolů souvisejících s konfigurací Apache Hadoop.

Úloha 1: První úloha v instalaci Hadoop zahrnovala nastavení šablony virtuálního stroje, která byla nakonfigurována pomocí Cent OS7. Byly staženy balíčky jako Java SDK 1.8 a Runtime Systems potřebné ke spuštění Hadoopu a proměnná prostředí Java pro Hadoop byla konfigurována úpravou bash_rc.

Úloha 2: Balíček Hadoop Release 2.7.4 byl stažen z webové stránky apache a byl extrahován do složky opt. Který byl pro snadný přístup přejmenován na Hadoop.

Úkol 3: Jakmile byly balíčky Hadoop extrahovány, další krok zahrnoval konfiguraci proměnné prostředí pro uživatele Hadoop následovanou konfigurací souborů XML Hadoop uzlu. V tomto kroku byl NameNode nakonfigurován v rámci core-site.xml a DataNode byl nakonfigurován v hdfs-site.xml. Správce zdrojů a správce uzlů byly nakonfigurovány v rámci příze-site.xml.

Úkol 4: Firewall byl deaktivován za účelem spuštění YARN a DFS. Příkaz JPS byl použit k ověření, zda jsou na pozadí spuštěny relevantní démoni. Číslo portu pro přístup k Hadoop bylo nakonfigurováno na http: // localhost: 50070 /

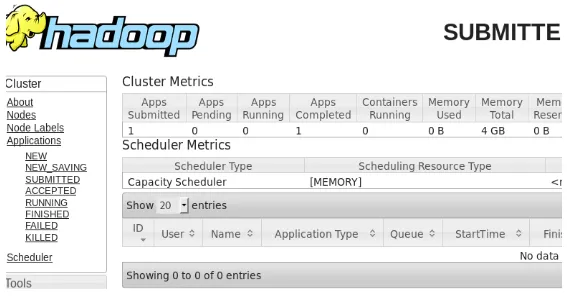

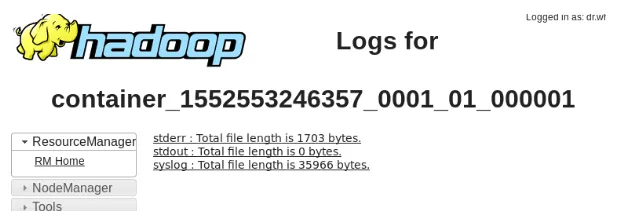

Úkol 5: K ověření a testování Hadoopu bylo použito několik následujících kroků. Za tímto účelem jsme vytvořili dočasný testovací soubor ve vstupním adresáři pro program WordCount. Ke snížení počtu slov v souboru byl použit program Hadoop-MapReduce-priklady2.7.4.jar. Výsledky byly vyhodnoceny na localhost a byly analyzovány protokoly předložené aplikace. Všechny odeslané aplikace MapReduce lze zobrazit v online rozhraní, výchozí číslo portu je 8088.

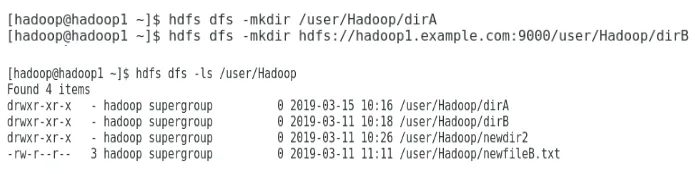

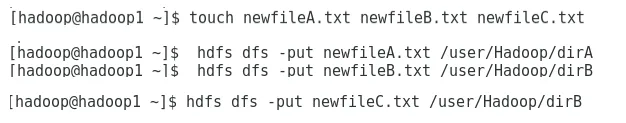

Úkol 6: V závěrečné úloze představíme některé základní příkazy systému souborů Hadoop a zkontrolujeme jejich použití. Uvidíme, jak je možné v adresářovém systému Hadoop vytvořit adresář, abychom uvedli obsah adresáře, jeho velikost v bajtech. Dále uvidíme, jak odstranit konkrétní adresář a soubor.

Výsledky instalace Hadoop

Následující ukazuje výsledky každého z výše uvedených úkolů:

Výsledek úkolu 1

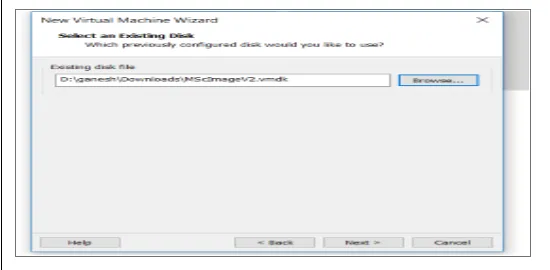

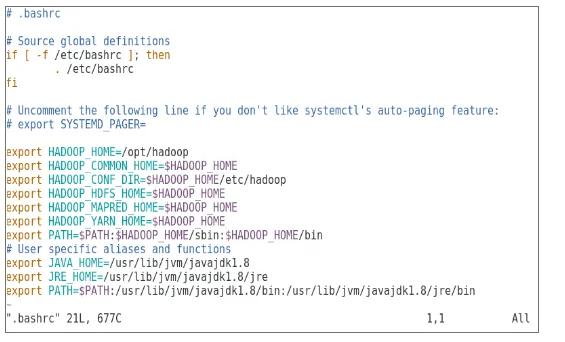

Pro provoz Apache Hadoop byl nakonfigurován nový virtuální počítač s obrazem cenOS7. Obrázek 1 ukazuje, jak byl obraz CenOS 7 nakonfigurován ve virtuálním stroji. Obrázek 1.2 ukazuje konfiguraci proměnné prostředí JAVA v prostředí .bash_rc.

Obrázek 1: Konfigurace virtuálního počítače

Obrázek 1.2: Konfigurace proměnné prostředí Java

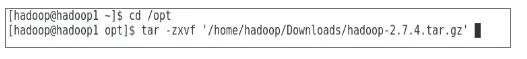

Výsledek úkolu 2

Obrázek 2 ukazuje úkol provedený za účelem extrahování balíčku Hadoop 2.7.4 do složky opt.

Obrázek 2: Extrakce balíčku Hadoop 2.7.4

Výsledek úkolu 3

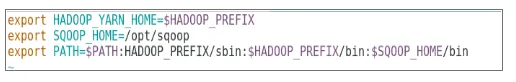

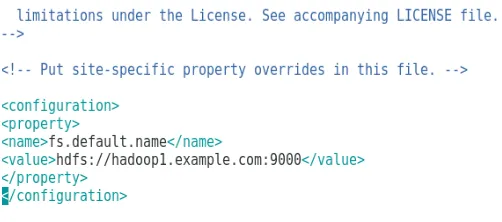

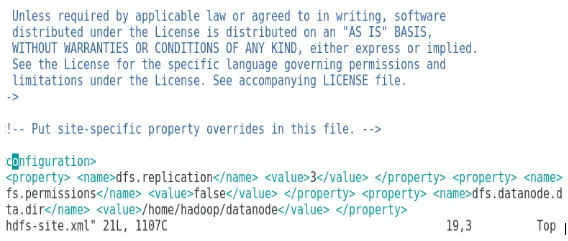

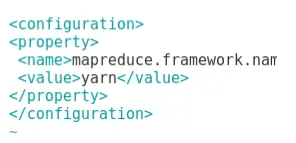

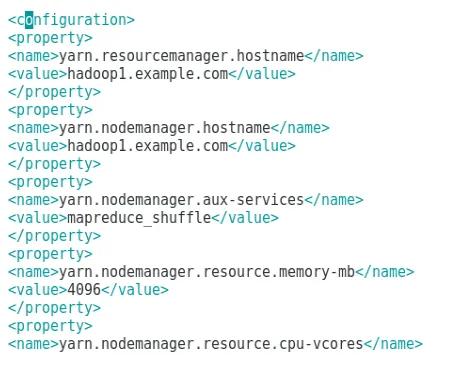

Obrázek 3 ukazuje konfiguraci proměnné prostředí pro uživatele Hadoop, obrázek 3.1 až 3.4 ukazuje konfiguraci pro soubory XML požadované pro konfiguraci Hadoop.

Obrázek 3: Konfigurace proměnné prostředí pro uživatele Hadoop

Obrázek 3.1: Konfigurace core-site.xml

Obrázek 3.2: Konfigurace hdfs-site.xml

Obrázek 3.3: Konfigurace souboru mapred-site.xml

Obrázek 3.4: Konfigurace souboru příze-site.xml

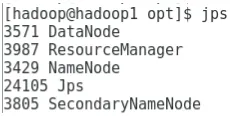

Výsledek úkolu 4

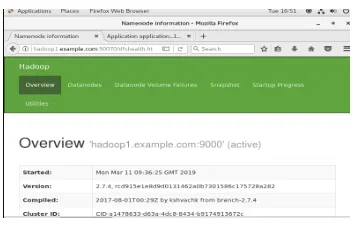

Obrázek 4 ukazuje použití příkazu jps ke kontrole příslušných démonů běžících na pozadí a následující obrázek ukazuje online uživatelské rozhraní Hadoopu.

Obrázek 4: Příkaz jps k ověření běžících démonů.

Obrázek 4.1: Přístup k online rozhraní Hadoop na portu http://hadoop1.example.com:50070/

Výsledek úkolu 5

Obrázek 5 ukazuje výsledek programu MapReduce nazvaný wordcount, který počítá počet slov v souboru. Dalších několik čísel zobrazuje online uživatelské rozhraní správce prostředků YARN pro zadanou úlohu.

Obrázek 5: Výsledky programu MapReduce

Obrázek 5.1: Odeslaná aplikace pro snížení mapy.

Obrázek 5.2: Protokoly pro přihlášenou aplikaci MapReduce.

Výsledek úkolu 6

Obrázek 6 ukazuje, jak vytvořit adresář v systému souborů Hadoop a provést výpis adresáře hdfs.

Obrázek 6: Vytvoření adresáře v systému souborů Hadoop

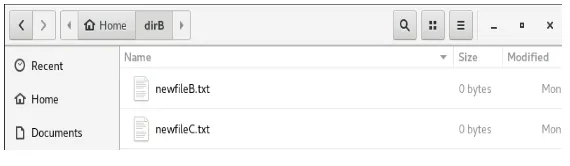

Obrázek 6.1 ukazuje, jak umístit soubor do distribuovaného systému souborů Hadoop a obrázek 6.2 ukazuje vytvořený soubor v adresáři dirB.

Obrázek 6.1: Vytvoření souboru v HDFS.

Obrázek 6.2: Byl vytvořen nový soubor.

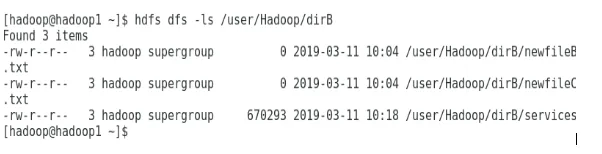

Několik následujících obrázků ukazuje, jak vypsat obsah jednotlivých adresářů:

Obrázek 6.3: Obsah dirA

Obrázek 6.4: Obsah dirB

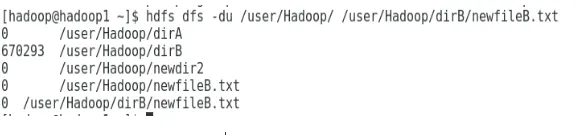

Následující obrázek ukazuje, jak lze zobrazit velikost souboru a adresáře:

Obrázek 6.5: Zobrazení velikosti souboru a adresáře.

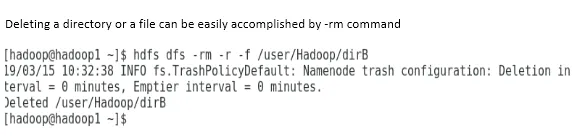

Odstranění adresáře nebo souboru lze snadno provést příkazem -rm.

Obrázek 6.6: Odstranění souboru.

Závěr

Big Data sehrála velmi důležitou roli při utváření dnešního světového trhu. Hadoop framework usnadňuje život analytiků dat při práci na rozsáhlých souborech dat. Konfigurace Apache Hadoop byla poměrně jednoduchá a online uživatelské rozhraní poskytovalo uživateli více možností vyladění a správy aplikace. Hadoop byl v organizacích hojně využíván pro ukládání dat, analytiku strojového učení a zálohování dat. Správa velkého množství dat byla velmi užitečná kvůli distribuovanému prostředí Hadoop a MapReduce. Vývoj Hadoop byl ve srovnání s relačními databázemi úžasný, protože jim chyběly možnosti ladění a výkonu. Apache Hadoop je uživatelsky přívětivé a levné řešení pro efektivní správu a ukládání velkých dat. HDFS také pomáhá při ukládání dat.

Doporučené články

Toto je průvodce instalací Hadoop. Zde diskutujeme úvod k Instal Hadoop, krok za krokem instalace Hadoop spolu s výsledky instalace Hadoop. Další informace naleznete také v dalších navrhovaných článcích -

- Úvod do streamování Hadoop

- Co je Hadoop Cluster a jak to funguje?

- Ekosystém Apache Hadoop a jeho komponenty

- Jaké jsou alternativy Hadoop?