Rozdíl mezi Malá a velká data

Small Data, není nic jiného než data, která jsou dostatečně malá pro člověka ve svazku a také pro formátování, díky čemuž je dostupná, informativní a použitelná. Tradiční zpracování dat nedokáže zpracovat velká ani složitá data, tato data se označují jako velká data. Když objem dat roste nad určitý limit, tradiční systémy a metodiky nestačí ke zpracování dat nebo k transformaci dat do užitečného formátu. To je důvod, proč jsou data obecně rozdělena do dvou - Small Data vs Big Data

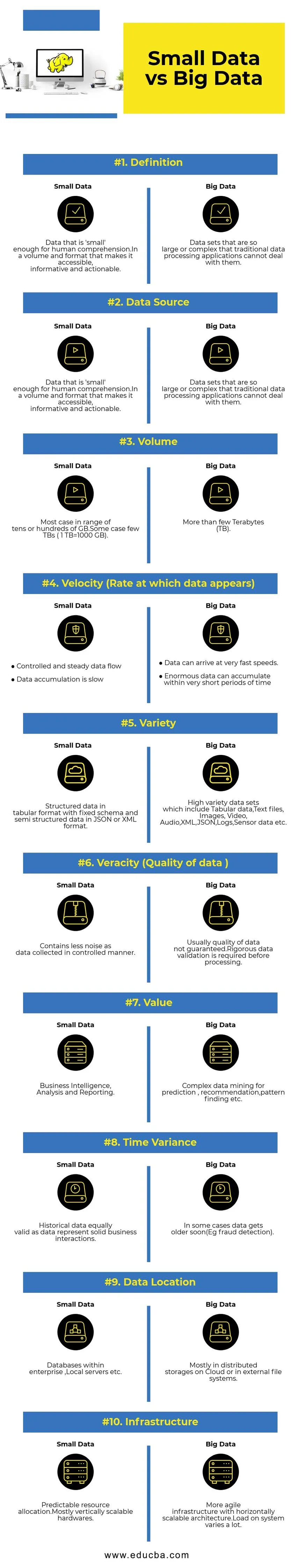

Srovnání mezi hlavami mezi malými daty a velkými daty (Infografika)

Níže je 10 největších rozdílů mezi malými a velkými daty

Klíčové rozdíly mezi malými daty a velkými daty

- Shromažďování dat - obvykle malá data jsou součástí systémů OLTP a shromažďují se kontrolovanějším způsobem a poté se vkládají do vyrovnávací vrstvy nebo databáze. Databáze budou mít v případě potřeby repliky pro podporu okamžitých analytických dotazů. Potrubí pro sběr velkých dat bude obsahovat fronty jako AWS Kinesis nebo Google Pub / Sub, aby bylo možné vyvážit vysokorychlostní data. Downstream bude mít streamovací potrubí pro analytiku v reálném čase a dávkové úlohy pro zpracování studených dat.

- Zpracování dat - Vzhledem k tomu, že většina malých dat generovaných prostřednictvím transakčního systému, bude analytika nad nimi většinu času dávkově orientována. Ve vzácných případech se analytické dotazy spouští přímo na transakčních systémech. Prostředí velkých dat budou mít jak potrubí pro zpracování dávek, tak i toky. Tok se používá pro analýzy v reálném čase, jako je detekce podvodů s kreditními kartami nebo predikce ceny akcií. Dávkové zpracování používané pro implementaci komplexní obchodní logiky s daty a pokročilými algoritmy.

- Škálovatelnost - malé datové systémy se obvykle měřítko svisle. Vertikální škálování zvyšuje kapacitu systému přidáním více zdrojů na stejný stroj. Vertikální škálování je nákladné, ale méně náročné na správu. Systémy Big Data většinou závisí na horizontálně škálovatelné architektuře, která poskytuje vyšší pohyblivost při nižších nákladech. Preventivní virtuální stroje dostupné v cloudu dělají horizontálně škálovatelné systémy ještě dostupnější.

- Modelování dat - malá data generovaná z transakčních systémů budou v normalizované podobě. Datové potrubíETL (Extract Transform Load) převádí data do schématu hvězd nebo sněhových vloček v datovém skladu. Zde je schéma vždy vynucováno při zápisu dat, která jsou relativně snadná, protože data jsou strukturovanější. Jak bylo uvedeno výše, tabelární data jsou pouze zlomkem velkých dat. Zde jsou data replikována mnohem více z různých důvodů, jako je předávání selhání nebo kvůli určitému omezení základního databázového stroje (Například, některé databáze podporují pouze jeden sekundární index na datovou sadu). Při psaní není schéma vynuceno. Místo toho je schéma ověřeno při čtení dat.

- Spojování úložiště a výpočtů - V tradičních databázích, které většinou zpracovávají malá data, jsou úložiště a výpočetní technika pevně spojeny. Vkládání a načítání dat do az databáze je možné pouze prostřednictvím daného rozhraní. Data nemohou být vložena přímo do databázového souborového systému nebo existující data nemohou být dotazována pomocí jiných databázových strojů. Tato architektura ve skutečnosti pomáhá zajistit integritu dat. Systémy Big Data mají velmi volné propojení mezi úložištěm a výpočtem. Obvykle jsou data ukládána v distribuovaném systému pro ukládání dat, jako je HDFS, AWS S3 nebo Google GCS, a výpočetní modul pro dotazování dat nebo výběr ETL později. Interaktivní dotazy mohou být například prováděny pomocí Presto (Link) a ETL pomocí Apache Hive na stejných datech.

- Data Science - Algoritmy strojového učení vyžadují vstupní data v dobře strukturovaném a správně kódovaném formátu a většinu času budou vstupní data z obou transakčních systémů, jako je datový sklad a ukládání velkých dat jako datové jezero. Algoritmy strojového učení běžící výhradně na malých datech budou snadné, protože fáze přípravy dat je úzká. Příprava a obohacení dat v prostředí Big Data vyžaduje mnohem více času. Big Data nabízí mnoho možností pro experimentování s vědou o datech kvůli velkému množství a rozmanitosti dat.

- Zabezpečení dat - bezpečnostní postupy pro malá data, která jsou umístěna v podnikových datových skladech nebo transakčních systémech poskytovaných příslušnými poskytovateli databází, které mohou zahrnovat oprávnění uživatele, šifrování dat, hašování atd. Zabezpečení velkých datových systémů je mnohem složitější a náročnější. Mezi osvědčené postupy zabezpečení patří šifrování dat v klidu a při přenosu, izolace klastrové sítě, přísná pravidla řízení přístupu atd.

Tabulka porovnávání malých dat a velkých dat

| Základ srovnání | Malá data | Velká data |

| Definice | Data, která jsou „malá“ pro lidské porozumění. Ve svazku a formátu, který je činí přístupnými, informativními a použitelnými | Datové sady, které jsou tak velké nebo složité, že tradiční aplikace pro zpracování dat s nimi nemohou jednat |

| Zdroj dat | ● Data z tradičních podnikových systémů, jako jsou Planning Plánování podnikových zdrojů Management Řízení vztahů se zákazníky (CRM) ● Finanční údaje jako data hlavní knihy ● Údaje o platebních transakcích z webu | ● Nákup dat z prodejního místa ● Clickstream data z webových stránek ● GPS stream data - Data mobility odeslaná na server ● Sociální média - facebook, twitter |

| Objem | Většina případů v rozsahu desítek nebo stovek GB.Některé případy málo TB (1 TB = 1 000 GB) | Více než několik terabajtů (TB) |

| Rychlost (rychlost, při které se data objevují) | ● Řízený a stabilní tok dat ● Akumulace dat je pomalá | ● Data mohou dorazit velmi rychle. ● Obrovská data se mohou hromadit ve velmi krátkém časovém období |

| Odrůda | Strukturovaná data v tabulkovém formátu s pevným schématem a polostrukturovaná data ve formátu JSON nebo XML | Velmi rozmanité datové sady, které zahrnují tabulková data, textové soubory, obrázky, video, audio, XML, JSON, protokoly, data senzorů atd. |

| Věrnost (kvalita dat) | Obsahuje méně hluku jako data shromažďovaná kontrolovaným způsobem. | Kvalita dat obvykle není zaručena. Před zpracováním je třeba důkladně ověřit data. |

| Hodnota | Business Intelligence, analýza a reporting | Komplexní těžba dat pro predikci, doporučení, nalezení vzoru atd. |

| Časová odchylka | Historická data stejně platná jako data představují solidní obchodní interakce | V některých případech se data brzy stárnou (např. Detekce podvodů). |

| Umístění dat | Databáze v rámci podniku, lokální servery atd. | Většinou v distribuovaných úložištích v cloudu nebo v externích souborových systémech. |

| Infrastruktura | Předvídatelné přidělení prostředků. Nejvíce vertikálně škálovatelný hardware | Agilnější infrastruktura s horizontálně škálovatelnou architekturou. Zatížení systému se velmi liší. |

Závěr - Malá data vs Velká data

Konečným cílem analýzy dat je získat včasný přehled o podpoře rozhodování. Rozdělení dat do malých a velkých pomáhá řešit problémy při analýze dat z každého světa samostatně pomocí vhodných nástrojů. Hranice mezi dvěma kategoriemi se liší podle nově vznikajících pokročilých systémů zpracování dat, díky nimž jsou i dotazování velkých dat mnohem rychlejší a méně složité.

Doporučené články:

Byl to průvodce malými daty a velkými daty, jejich významem, vzájemným porovnáváním, klíčovými rozdíly, srovnávací tabulkou a závěrem. Tento článek obsahuje všechny důležité rozdíly mezi malými a velkými daty. Další informace naleznete také v následujících článcích -

- Big Data vs Data Science - Jak se liší?

- Velká data: Důležitá je souvislost analytiky technologie a podnikání

- Top 5 velkých datových trendů, které budou společnosti muset zvládnout

- 16 zajímavých tipů, jak převést velká data na velký úspěch