Co je to Apache Hadoop Ecosystem?

Apache Hadoop Ecosystem je framework nebo open-source datová platforma určená k ukládání a zkoumání obrovských sbírek dat nestrukturovaných. Na celém světě existuje velké množství dat poháněných z mnoha digitálních platforem s přední inovativní technologií velkých dat. Apache Hadoop byl navíc první, kdo získal tento proud inovací.

Co zahrnuje architekturu / ekosystém Hadoop Data?

Hadoop Ecosystem není programovací jazyk nebo služba, je to rámec nebo platforma, která se stará o velké datové problémy. Můžete jej identifikovat jako sadu, která zahrnuje různé služby, jako je ukládání, přijímání, údržba a analýza uvnitř. Poté prozkoumejte a získejte stručnou představu o tom, jak služby fungují výhradně a ve spolupráci. Architektura Apache Hadoop zahrnuje různé inovace a prvky Hadoop, díky nimž lze efektivně vyřešit i složité informační problémy.

Následuje zobrazení každé části: -

1) Namenode: Vede proces informací

2) Datanode: Skládá informace do místního úložiště. Ukládání všech informací na jediné místo se nepřetržitě nenavrhuje, protože by to mohlo způsobit ztrátu informací v případě výpadku.

3) Sledovač úloh: Dostávají povinnosti přidělené podřízenému uzlu

4) Mapa: Převezme informace z proudu a každý řádek je zpracován rozdělen do části do různých polí

5) Zmenšit: Zde jsou pole, získaná prostřednictvím Map, shromážděna nebo vzájemně propojena

Ekosystém Apache Hadoop - krok za krokem

Každý prvek ekosystému Hadoop, jak jsou zřejmé konkrétní aspekty. Komplexní pohled na strukturu Hadoop nabízí pozoruhodnou kvalitu pro Hadoop Distributed File Systems (HDFS), Hadoop YARN, Hadoop MapReduce a Hadoop MapReduce z ekosystému Hadoop. Hadoop dokonce poskytuje každé knihovně Java, významné Java záznamy, odrazy na úrovni OS, výhody a skripty pro provozování Hadoop. Hadoop YARN je metoda pro obchodní načrtávání a správu zdrojů partií. V konfiguraci Hadoop poskytuje HDFS vysoký propustnost informací o aplikacích a Hadoop MapReduce poskytuje paralelní přípravu rozsáhlých datových sortimentů na bázi YARN.

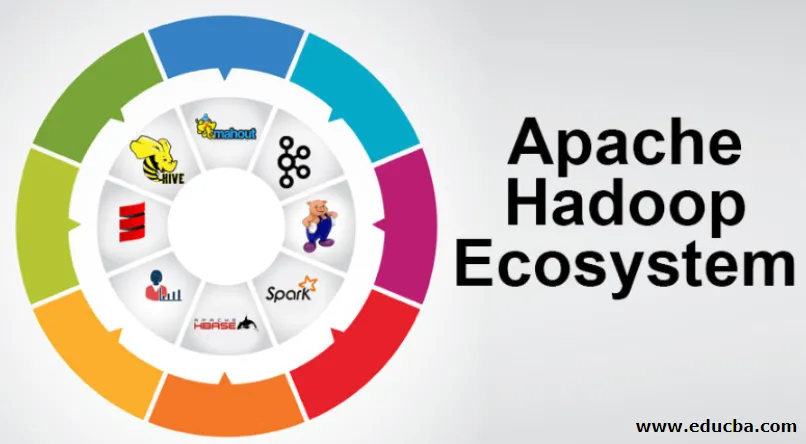

Přehled ekosystémů Apache Hadoop

Než začnete pracovat s ekosystémem Hadoop, je to základní téma, kterému musíte porozumět. Níže jsou uvedeny základní součásti:

- HDFS: Toto je centrální část ekosystému Hadoop a může ušetřit obrovské množství nestrukturovaných, strukturovaných a polostrukturovaných informací.

- YARN: Připomíná to mysl ekosystému Hadoop a veškerá manipulace se provádí přímo zde, což může zahrnovat alokaci aktiv, plánování úloh a přípravu akcí.

- MapReduce: Jedná se o směs dvou procesů, které jsou popsány jako Map and Reduce, a sestává z podstaty přípravy částí skládajících obrovské informační kolekce využívající paralelní a rozptýlené algoritmy uvnitř ekosystému Hadoop.

- Apache Pig: Je to jazyk procedury, který se používá pro aplikace pro paralelní zpracování ke zpracování rozsáhlých informačních kolekcí v Hadoop stavu a tento jazyk je volbou pro programování v Java.

- HBase: Jedná se o open-source a nepřidruženou nebo NoSQL databázi. Posiluje všechny typy informací, takže může řešit jakýkoli typ informací uvnitř rámce Hadoop.

- Mahout, Spark MLib: Mahout je využíván pro strojové učení a dává přirozenost vytváření aplikací pro strojové učení.

- Zookeeper: Pro jednání se skupinami lze Zookeeper využít, jinak se nazývá pán koordinace, který může poskytnout spolehlivé, rychlé a vytříděné provozní správy pro hrozny Hadoop.

- Oozie: Apache Oozie provádí plánování práce a pracuje jako výstražné a hodinové služby v ekosystému Hadoop.

- Ambari: Je to závazek Apache Software Foundation a může provádět ekosystém Hadoop progresivně flexibilní.

Hadoop YARN:

Přemýšlejte o YARN jako o mysli vašeho ekosystému Hadoop. Hraje celé vaše operace zpracování přidělením aktiv a plánovacích povinností.

Má dva pozoruhodné segmenty, kterými jsou ResourceManager a NodeManager.

- ResourceManager: - Je to opět hlavní uzel v provozní divizi. Dostane přípravné dotazy a poté předá části dotazů příslušným NodeManagers, kde dochází ke skutečné manipulaci.

- NodeManagers: - Jsou nainstalovány v každém DataNode. Je zodpovědný za provedení přiřazení v každém DataNode.

Jak apache Hadoop funguje?

- Záměrem je vzestup od jednotlivých serverů k obrovskému množství strojů, z nichž každý poskytuje místní výpočet a kapacitu. Namísto toho, aby byla knihovna závislá na vybavení umožňujícím vysokou přístupnost, je určena k tomu, aby rozlišovala a řešila zklamání na aplikační vrstvě, a tak zprostředkovávala mimořádně přístupnou službu na spoustě počítačů, z nichž každý by mohl být nakloněn zklamání.

- Podívejte se však dále a v práci se výrazně zvyšuje kouzlo. Hadoop je zcela modulární, což znamená, že můžete vyměnit prakticky jakýkoli ze svých segmentů za alternativní softwarový nástroj. Díky tomu je architektura fantasticky přizpůsobivá, stejně výkonná a efektivní.

Apache Hadoop Spark:

- Apache Spark je systém pro analýzu informací v reálném čase v rozptýleném výpočetním prostředí. Implementuje výpočty v paměti pro zvýšení rychlosti zpracování informací.

- Je to rychlejší pro zpracování rozsáhlých informací, protože využívá výpočty v paměti a různá vylepšení. Podél těchto linií vyžaduje vysokou zpracovatelskou sílu.

Jak Apache Pig funguje?

- Apache Pig je prospěšný systém, který společnost Yahoo vyvinula, aby efektivně a hladce prozkoumala obrovské informační pozice. Poskytuje několik špičkových jazyků informačních toků Pig Latin, které jsou vylepšené, rozšiřitelné a snadno použitelné.

- Výjimečná součást programů vepře, ve kterých je jejich složení k dispozici pro podstatnou paralelizaci, což usnadňuje péči o podstatné informační sbírky.

Případ použití prasete:

- Informace o soukromé zdravotní péči jednotlivce jsou soukromé a neměly by být poskytovány jiným lidem. Tato data by měla být utajena, aby byla zachována mlčenlivost, ale informace o lékařských službách jsou obrovské do té míry, že je nezbytné rozpoznat a vyloučit jednotlivé informace o zdravotní péči. Apache Pig lze za takových podmínek využít k rozeznání zdravotních údajů.

Závěr:

- Je navrženo, aby vystoupal z jednoho serveru na obrovské množství počítačů, všechny poskytují výpočet a kapacitu v okolí. Podívejme se však dále a v práci je stále okouzlující.

- Hadoop je zcela modulární, což znamená, že můžete vyměnit prakticky jakoukoli jeho část za alternativní softwarový nástroj. Díky tomu je struktura fantasticky přizpůsobivá, stejně výkonná a efektivní.

Doporučené články

Toto byl průvodce Ekosystémem Apache Hadoop. Zde diskutujeme o tom, co je Apache Hadoop Ecosystem? přehled architektury Hadoop a fungování ekosystému Hadoop. Další informace naleznete také v dalších navrhovaných článcích -

- Komponenty ekosystému Hadoop

- Jak nainstalovat Apache

- Apache Spark Training

- Kariéra v Hadoopu