Úvod do příkazů Hadoop fs

V tomto článku projdeme příkazy pro práci se soubory HADOOP, které se používají pro správu souborů prostřednictvím konzoly.

Budete potřebovat systém Linux a nejnovější verzi Hadoop. Chcete-li vytisknout verzi Hadoop, abyste věděli, kdo byl vydání vytvořen, je třeba zkontrolovat hodnotu kontrolního součtu, kterou po spuštění do platformy Hadoop potřebujeme provést níže uvedený příkaz.

Příkaz: Hadoop verze

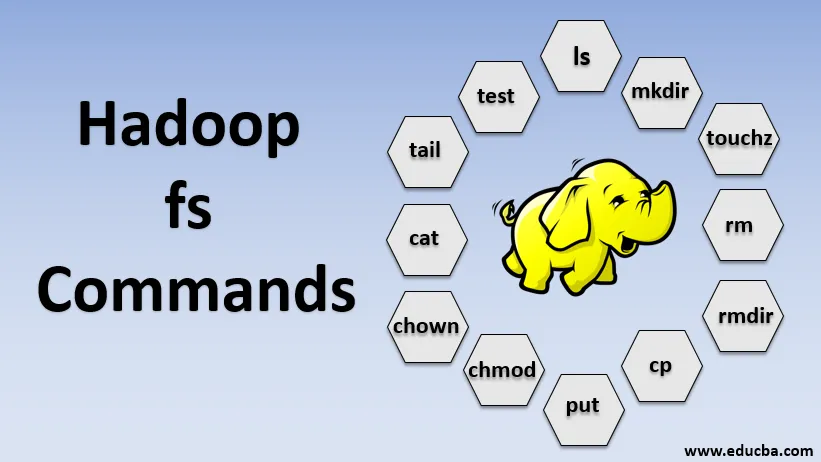

Příkazy Hadoop fs

Nyní se naučíme, jak používat příkazy HADOOP fs.

Začneme základy. Stačí zadat tyto příkazy do PUTTY nebo libovolné konzoly, se kterou jste spokojeni.

1. hadoop fs -ls

U adresáře vrací seznam souborů a adresářů, zatímco u souboru vrací statistiky souboru.

hadoop fs -lsr: Toto je pro rekurzivní výpis adresářů a souborů ve specifických složkách.

- Příklad : hadoop fs -ls / nebo hadoop fs -lsr

- -d: Slouží k výpisu adresářů jako obyčejných souborů.

- -h: Používá se k formátování velikostí souborů způsobem, který je čitelný člověkem, než jen počtem bajtů.

- -R: Používá se k rekurzivnímu výpisu obsahu adresářů.

2. hadoop fs -mkdir

Tento příkaz vezme cestu jako argument a vytvoří adresáře v hdfs.

- Příklad : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Vytváří prázdný soubor a nevyužívá žádné místo

- Příklad: hadoop fs -touchz URI

4. hadoop fs -rm

Odstraňte soubory zadané jako argument. Pro odstranění celého adresáře musíme zadat volbu -r. A pokud je zadána volba -skipTrash, přeskočí koše a soubor bude okamžitě odstraněn.

- Příklad : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs-rmdir

Odstraňuje soubory a oprávnění adresářů a podadresářů. V zásadě jde o rozšířenou verzi Hadoop fs -rm.

6. hadoop fs -cp

Zkopíruje soubor z jednoho umístění do druhého

- Příklad : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyOdstranka

Zkopíruje soubor z edgenode do HDFS.

8. hadoop fs -put

Zkopíruje soubor z edgenode do HDFS, je podobný předchozímu příkazu, ale dá také přečte vstup ze standardního vstupu stdin a zapíše do HDFS

- Příklad : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Příznak zachovává přístup, čas změny, vlastnictví a režim.

hadoop fs -put -f: Tento příkaz přepíše cíl, pokud soubor již existuje před kopií.

9. hadoop fs -moveFromLocal

Je to podobné kopírování z lokálního, s výjimkou toho, že po zkopírování do HDFS se zdrojový soubor z lokálního edgenodu odstraní

- Příklad : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Zkopíruje soubor z HDFS do edgenode.

- Příklad : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Tento příkaz nám pomáhá změnit přístup k souboru nebo adresáři

- Příklad : hadoop fs -chmod (-R) (cesta)

12. hadoop fs -chown

Tento příkaz nám pomáhá změnit vlastnictví souboru nebo adresáře

- Příklad : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Vytiskne obsah souboru HDFS na terminálu

- Příklad : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Zobrazuje poslední KB souboru HDFS ke stdout

- Příklad : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Tento příkaz se používá pro operace testu souborů HDFS, vrátí 0, pokud je pravdivé.

- - e: zkontroluje, zda soubor existuje.

- -z: zkontroluje, zda je soubor nulové délky

- -d / -f: zkontroluje, zda je cesta adresářem / souborem

Zde diskutujeme podrobně příklad

- Příklad : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Zobrazuje velikosti souborů a adresářů obsažených v daném adresáři nebo délku souboru v případě, že se jedná o soubor

17. hadoop fs -df

Zobrazuje volné místo

18. hadoop fs -checksum

Vrátí informace o kontrolním součtu souboru

19. hadoop fs -getfacl

Zobrazuje seznam řízení přístupu (ACL) konkrétního souboru nebo adresáře

20. hadoop fs -count

Počítá počet adresářů, souborů a bajtů pod cestou, která odpovídá zadanému vzoru souboru.

21. hadoop fs -setrep

Mění faktor replikace souboru. A pokud je cesta adresářem, příkaz změní faktor replikace všech souborů v adresáři.

- Příklad : hadoop fs -setrep -R / user / datahub: používá se k přijetí zpětné schopnosti a nemá žádný účinek.

hadoop fs - setrep -w / user / datahub : čeká na dokončení replikace

22. hadoop fs -getmerge

Zřetězuje soubory HDFS ve zdroji do cílového lokálního souboru

- Příklad : hadoop fs -getmerge / user / datahub

23. hadoop fs -endendooile

Připojí jeden zdroj nebo více zdrojů z místního systému souborů do cíle.

- Příklad : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Vytiskne statistiky o souboru nebo adresáři.

- Příklad : hadoop fs -stat (formát)

Závěr - Hadoop fs Příkazy

Prošli jsme tedy téměř všechny příkazy, které jsou nezbytné pro práci se soubory a prohlížíme si data uvnitř souborů. Nyní můžete své soubory a přijímat data upravovat do platformy Hadoop.

Doporučené články

Toto je průvodce příkazy Hadoop fs. Zde diskutujeme podrobně úvod do příkazů Hadoop fs a jeho příklad. Další informace naleznete také v následujících článcích

- Nainstalujte Hadoop

- Hadoop Tools

- Hadoop architektura

- Hadoop Components

- Hadoop fs Příkazy