Úvod do Hadoop Framework

Než se do hloubky ponoříme do technického rámce Hadoop, začneme jednoduchým příkladem.

Existuje farma, která sklízí rajčata a ukládá je do jediného skladovacího prostoru, nyní se zvyšující se poptávkou po zelenině začala sklízet brambory, mrkev - se zvyšující se poptávkou byl nedostatek farmářů, takže najali více farmářů. Po nějaké době si uvědomili, že v skladovacím prostoru je nedostatek - tak distribuovali zeleninu do různých skladovacích prostor. Pokud jde o načítání dat, všechny pracují paralelně s vlastním úložným prostorem.

Jak tedy souvisí tento příběh s velkými daty?

Dříve jsme měli omezená data, s omezeným procesorem a jednou úložnou jednotkou. Ale pak se generování dat zvýšilo, což vedlo k velkému objemu a různým variantám - strukturované, polostrukturované a nestrukturované, takže řešením bylo použít distribuované úložiště pro každý procesor, což umožnilo snadný přístup k ukládání a přístupu k datům.

Takže nyní můžeme zeleninu nahradit jako různé druhy dat a úložiště jako distribuovaná místa pro ukládání dat a různí pracovníci jsou každý procesor.

Takže velká data jsou výzvou a Hadoop hraje roli v řešení.

HADOOP

1. Řešení pro BIG DATA: protože se zabývá složitostí velkého objemu, rychlosti a rozmanitosti dat.

2. Sada open-source projektu.

3. Spolehlivě ukládá obrovské množství dat a umožňuje obrovské distribuované výpočty.

4. Klíčovými atributy Hadoop jsou redundance a spolehlivost (absolutně žádná ztráta dat).

5. Primárně se zaměřuje na dávkové zpracování.

6. Běží na komoditním hardwaru - nemusíte kupovat žádný speciální drahý hardware.

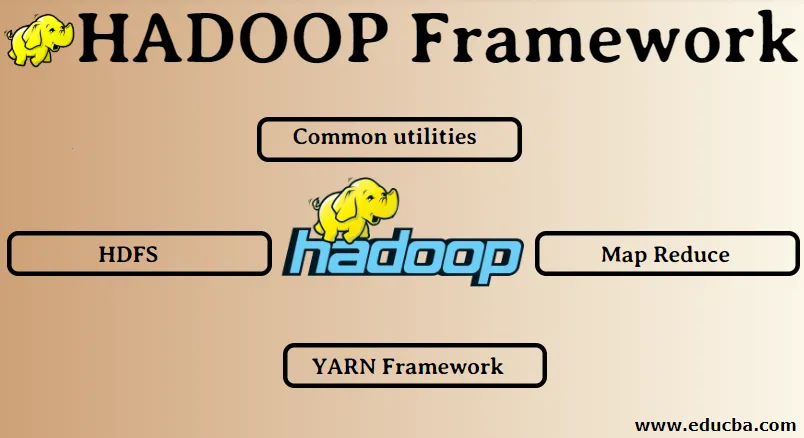

Hadoop Framework:

1. Běžné nástroje

2. HDFS

3. Mapa Zmenšit

4. YARN Framework

1. Běžné nástroje:

Také se nazýval Hadoop obyčejný. Toto nejsou nic jiného než knihovny, soubory, skripty a obslužné programy JAVA, které ostatní komponenty Hadoop ve skutečnosti vyžadují.

2. HDFS: Distribuovaný systém souborů Hadoop

Proč se společnost Hadoop rozhodla začlenit distribuovaný systém souborů?

Pojďme to pochopit na příkladu: Potřebujeme přečíst 1 TB dat a máme jeden stroj se 4 I / O kanály, každý kanál má 100 MB / s, čtení všech dat trvalo 45 minut. Nyní stejné množství dat čte 10 strojů, každý se 4 I / O kanály, přičemž každý kanál má 100 MB / s. Hádejte, kolik času trvalo čtení dat? 4, 3 minuty. HDFS řeší problém ukládání velkých dat. Dvě hlavní složky systému HDFS jsou NAME NODE a DATA NODE. Uzel jména je hlavní, můžeme mít také sekundární uzel názvů, pokud primární uzel názvů přestane fungovat, uzel sekundárních jmen bude fungovat jako záloha. Uzel názvu v podstatě udržuje a spravuje datové uzly ukládáním metadat. Datový uzel je slave, což je v podstatě nízkonákladový komoditní hardware. Můžeme mít více datových uzlů. Datový uzel ukládá skutečná data. Tento datový uzel podporuje replikační faktor, předpokládejme, že pokud jeden datový uzel klesne, data mohou být zpřístupněna druhým replikovaným datovým uzlem, proto je přístupnost dat zlepšena a je zabráněno ztrátě dat.

3. Zmenšit mapu:

Řeší problém zpracování velkých dat. Podívejme se, jak se koncept mapy zmenšuje řešením tohoto problému v reálném světě. Společnost ABC chce vypočítat své celkové tržby po městě. Nyní zde nefunguje koncept hashovací tabulky, protože data jsou v terabajtech, takže použijeme koncept Map-Reduce.

Existují dvě fáze: a) MAP. b) SNÍŽENÍ

a) Mapa : Nejprve rozdělíme data na menší kousky nazývané mapovače na základě páru klíč / hodnota. Klíčem tedy bude název města a hodnota bude celkový prodej. Každý mapovač získá každý měsíc data, která obsahují název města a odpovídající prodeje.

b) Omezit: Dostane tyto hromady dat a každý reduktor bude odpovědný za města sever / západ / východ / jih. Práce reduktoru tedy bude shromažďovat tyto malé kousky a převádět na větší množství (jejich sčítáním) pro konkrétní město.

4.YARN Framework: Ještě jeden vyjednávač zdrojů.

Počáteční verze Hadoopu měla pouze dvě komponenty: Map Reduce a HDFS. Později se zjistilo, že Map Reduce nedokáže vyřešit mnoho velkých datových problémů. Záměrem bylo zbavit zodpovědnosti za správu zdrojů a plánování úloh od starého motoru snižujícího mapy a dát ho nové součásti. Tak na to přišel YARN. Je to prostřední vrstva mezi HDFS a Map Reduce, která je zodpovědná za správu prostředků klastru.

Má dvě klíčové role: a) Plánování úloh. b) Správa zdrojů

a) Plánování úloh: Když dává velké množství dat ke zpracování, musí být distribuována a rozdělena do různých úkolů / úloh. Nyní JS rozhodne, která úloha musí mít nejvyšší prioritu, časový interval mezi dvěma úlohami, závislost mezi úlohami, zkontroluje, zda nedochází k překrývání mezi spuštěnými úlohami.

b) Správa zdrojů: Pro zpracování dat a pro ukládání dat potřebujeme zdroje, ne? Správce zdrojů tedy poskytuje, spravuje a udržuje zdroje pro ukládání a zpracování dat.

Takže nyní máme jasno o konceptu Hadoopu a o tom, jak řeší výzvy vytvořené velkými údaji !!!

Doporučené články

Toto byl průvodce Hadoop Frameworkem. Zde jsme také diskutovali o top 4 rámcích Hadoop. Další informace naleznete také v dalších navrhovaných článcích -

- Hadoop databáze

- Hadoop Ekosystém

- Použití Hadoopu

- Pracovní místa správce Hadoop

- Správce Hadoopu Dovednosti a kariérní cesta