Jak nainstalovat Úl?

Apache Hadoop je kolekce frameworku, která umožňuje zpracování velkých dat distribuovaných v klastru. Podle Apache Hive je softwarový projekt datového skladu postavený na Apache Hadoop pro poskytování dotazů a analýz dat. Úl Apache poskytuje rozhraní typu SQL pro dotazování a zpracování velkého množství dat zvaných HQL (dotazovací jazyk Hive). Úl Apache běží nad ekosystémem Hadoop a data uložená ve formě souboru znamenají distribuovaný systém souborů Hadoop (HDFS). Apache Hive poskytuje uživateli skvělé rozhraní pro přístup a provádění operací s daty ve formě tabulky, poskytuje skvělou optimalizační techniku pro zlepšení výkonu. Je velmi náročné zrychlit dotaz s velkými daty a věřit mi, že je to důležité v produkčním prostředí.

V backendu kompilátor převádí dotaz HQL na mapu a snižuje počet úloh a poté je odesílá do rámce Hadoop k provedení.

Rozdíl mezi Úlem a SQL

Apache Hive je velmi podobný s SQL, ale jak víme, úl běží na vrcholu ekosystému Hadoop a interně převádí úlohy do MR (Map Reduce jobs), to dělá nějaký rozdíl mezi Hive a SQL.

Úl by nebyl nejlepším přístupem pro ty aplikace, kde je vyžadována velmi rychlá reakce a je velmi důležité pochopit, že Hive je vhodnější pro dávkové zpracování velmi rozsáhlých souborů neměnných dat, a měli bychom si uvědomit, že Hive je pravidelný RDBMS a v poslední době ale v neposlední řadě apache úl je schéma na čtecích prostředcích (při vkládání dat do tabulky podregistrů se nebude obtěžovat neshodami typu dat, ale při čtení dat se ukáže nulová hodnota, pokud datový typ neodpovídá datovému typu konkrétního sloupce).

Předchozí požadavek na instalaci podregistru

Jak jsem již řekl, je velmi důležité pochopit, že úly Apache běží na vrcholu Hadoop Ecosystem a Hadoop by měl být v provozu se všemi démony.

Některé ze základních démonů Hadoop jsou následující:

- Jmenný uzel

- Datový uzel

- Správce zdrojů

- Správce uzlů

Pro kontrolu verze Hadoop níže je příkaz:

Do příkazového řádku zadejte → Verze Hadoop, která vám poskytne verzi Hadoop.

Chcete-li zkontrolovat příkaz spouštění sestavy clusteru Hadoop níže:

Do příkazového řádku zadejte → Hadoop dfsadmin - ohlásí-li váš server, zobrazí se v příkazovém řádku celá zpráva klastru.

Pokud na vašem počítači není nainstalován program Hadoop, který vás žádá, abyste podle pokynů apache nainstalovali Hadoop do vašeho systému.

Doufám, že java již byl na vašem systému nainstalován. Chcete-li zkontrolovat verzi javy, viz níže obrázek obrazovky.

Kroky k instalaci Úlu na Ubuntu

Níže jsou uvedeny kroky k instalaci Úlu na Ubuntu:

Krok 1 : Úl dehtu si můžeme stáhnout pomocí příkazu níže v terminálu, který si také můžeme přímo stáhnout z terminálu.

Příkaz: dostaneme http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Krok 2 : Extrahujte dehtový soubor pomocí příkazu níže v terminálu, který můžeme extrahovat dehtu nad stažený dechtový dechový soubor dehtu.

Příkaz: tar -xzf apache-hive-2.1.0-bin.tar.gz

Navrhuji, abyste si ověřili příkazem ls o extrahovaném souboru úlu.

Krok 3: Upravte soubor „ .bashrc “ a aktualizujte proměnné prostředí pro uživatele.

Příkaz: sudo the .ashash

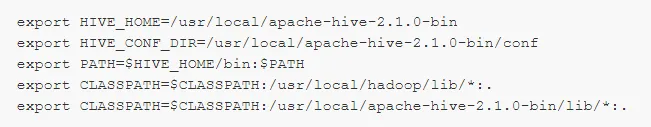

Na konec souboru přidejte následující text:

# Set HIVE_HOME

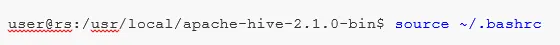

Spusťte níže uvedený příkaz k dokončení změn v aktuálním terminálu.

Příkaz: source .bashrc

Krok 5 : Musíme vytvořit adresáře Hive v umístění HDFS a v tomto adresáři 'skladu' bude místo, kde budou ukládány informace související s metadaty tabulky úlu a data související s Hive.

Příkaz :

- hdfs dfs -mkdir -p / user / hive / Veľkoobchod

- hdfs dfs -mkdir / tmp

Krok 6 : Chcete-li nastavit oprávnění pro čtení a zápis pro tabulku podregistrů, spusťte příkaz níže.

Příkaz:

V níže uvedeném příkazu udělujete skupině uživatelů oprávnění k zápisu:

- hdfs dfs -chmod g + w / user / hive / Veľkoobchod

- hdfs dfs -chmod g + w / tmp

Konfigurace podregistru: Je velmi důležité konfigurovat podregistr s Hadoop. Musíme upravit soubor hive-env.sh, který je umístěn v adresáři $ HIVE_HOME / conf. Následující příkazy přesměrovávají do složky Hive conf a zkopírují soubor šablony:

Krok 7 : Nastavte cestu Hadoop v souboru hive-env.sh

Upravte soubor hive-env.sh připojením následujícího řádku:

Nyní tímto procesem jsme téměř hotovi a instalace podregistru byly úspěšně dokončeny, je důležité nakonfigurovat Metastore s externím databázovým serverem a ve výchozím nastavení rámec Apache Hive používá databázi Derby. Pomocí níže uvedeného příkazu Inicializace Derby databáze.

Příkaz: bin / schematool -initSchema -dbType derby

Krok 8 : Spusťte úl .

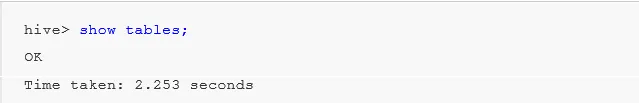

Příkaz: úl (typ úlu v terminálu v rámci druhého terminálu úlu se otevře.)

Práce s podregistrem: Nyní uvidíme některé operace v podregistru, abychom zjistili, kolik tabulek ve výchozí databázi používáme, viz níže screenshoty ve spodních screenshotech, nezobrazuje žádné tabulky, což znamená, že ve výchozí databázi nemáme žádné tabulky .

Pro vytvoření tabulky v podregistru je velmi důležité odkazovat na požadovanou databázi, jinak se jakákoli tabulka vytvoří pod výchozí databází.

Důležité příkazy v Úlu

1: show database (zobrazí všechny dosud vytvořené databáze).

2: vytvořte databázi, pokud neexistuje mydb (tento příkaz vytvoří jednu databázi s názvem ' mydb', pokud ' mydb' neexistuje a pokud ' mydb již existuje, nedá žádnou chybu')

3: použijte databázi, kdykoli musíme použít nějaký příkaz DDl na konkrétní databázi, měli bychom použít příkaz „use database“, v našem případě jsme již vytvořili příkaz „mydb“ show by se použil mydb.

Důležitý příkaz HL DDL

VYTVOŘENÍ, DROP, TRUNCATE, SHOW, DESCRIBE .

- Vytvořit : - Vytvořte příkaz používaný k vytvoření databáze nebo k vytvoření tabulky v podregistru.

Příklad: úl> create database Company; (vytvoření databáze)

Úl> používat společnost;

Úl> vytvořit tabulku zaměstnance (id int, name String, plat String); (Tím se vytvoří zaměstnanec tabulky v databázi Společnost, protože jsme již provedli příkaz Použít databázi.)

- Popis popisuje informace o schématu tabulky.

Úl> popsat zaměstnance; (podrobně se zobrazí podrobnosti schématu tabulky zaměstnanců)

- TRUNCATE odstraní data tabulky.

Úl> zkrátit tabulku zaměstnance;

Můžeme nainstalovat Úl na okno také, ale pro nejlepší praxi budu raději používat Ubuntu, poskytne lepší přehled o produkčním prostředí a vaše data se v budoucnu zvýší, bude snadná správa.

Doporučené články

Toto byl průvodce instalací podregistru. Zde jsme diskutovali o různých krocích instalace Hive, příkazu DDL atd. Další informace naleznete v následujících článcích:

- Jak nainstalovat SQL Server

- Jak nainstalovat MATLAB

- Příkazy a funkce úlu

- Základní otázky rozhovoru o úlu

- Architektura úlu Pracovní postup

- Použití funkce OBJEDNÁVKA BY v Úlu

- Instalace podregistru