Rozdíl mezi Hadoopem a Sparkem

Hadoop je open-source framework, který umožňuje ukládat a zpracovávat velká data v distribuovaném prostředí napříč klastry počítačů. Hadoop je navržen tak, aby se rozšířil z jednoho serveru na tisíce strojů, kde každý počítač nabízí místní výpočet a úložiště. Spark je počítač s otevřeným zdrojovým kódem určený pro rychlý výpočet. Poskytuje rozhraní pro programování celých klastrů s implicitní paralelitou dat a odolností proti chybám. Hlavním rysem programu Spark je výpočet clusterů v paměti, který zvyšuje rychlost aplikace.

Hadoop

- Hadoop je registrovaná ochranná známka softwarové nadace Apache. Využívá jednoduchý programovací model k provedení požadované operace mezi klastry. Všechny moduly v Hadoopu jsou navrženy se základním předpokladem, že poruchy hardwaru jsou běžné výskyty a měly by být řešeny rámcem.

- Spouští aplikaci pomocí algoritmu MapReduce, kde jsou data zpracovávána paralelně na různých uzlech CPU. Jinými slovy, rámec Hadoop je dostatečně schopný vyvíjet aplikace, které jsou dále schopné běžet na klastrech počítačů, a mohly provádět úplnou statistickou analýzu pro velké množství dat.

- Jádro Hadoopu se skládá z úložné části, která je známá jako distribuovaný systém souborů Hadoop, a ze zpracovávací části nazvané programovací model MapReduce. Hadoop v zásadě rozděluje soubory do velkých bloků a distribuuje je mezi klastry, přenáší kód balíčku do uzlů a zpracovává data paralelně.

- Tento datový soubor přístupu se zpracovává rychleji a efektivněji. Další moduly Hadoop jsou běžné Hadoop, což je svazek knihoven Java a utilit vrácených moduly Hadoop. Tyto knihovny poskytují abstrakci na úrovni souborového systému a operačního systému, obsahují také požadované soubory JavaScripty a skripty pro spuštění Hadoop. Hadoop Yarn je také modul, který se používá pro plánování úloh a správu prostředků klastru.

Jiskra

- Spark byl postaven na vrcholu modulu Hadoop MapReduce a rozšiřuje model MapReduce tak, aby efektivně využíval více typů výpočtů, které zahrnují interaktivní dotazy a zpracování datových proudů. Spark byl představen softwarovou nadací Apache, aby urychlil výpočetní softwarový proces Hadoop.

- Spark má vlastní správu clusterů a nejedná se o upravenou verzi Hadoop. Spark využívá Hadoop dvěma způsoby - jeden je úložiště a druhý je zpracování. Protože správa clusterů přichází ze samotné Spark, používá Hadoop pouze pro účely ukládání.

- Spark je jedním z podprojektů společnosti Hadoop, který byl vyvinut v roce 2009 a později se stal open source na základě licence BSD. Má spoustu úžasných funkcí, úpravou určitých modulů a začleněním nových modulů. Pomáhá spouštět aplikaci v clusteru Hadoop, několikrát rychleji v paměti.

- To je možné snížením počtu operací čtení / zápisu na disk. Ukládá data přechodného zpracování do paměti, čímž šetří operace čtení a zápisu. Spark také poskytuje zabudovaná rozhraní API v jazyce Java, Python nebo Scala. Lze tedy psát aplikace několika způsoby. Spark poskytuje nejen strategii Map a Reduce, ale také podporuje dotazy SQL, Streamování dat, Strojové učení a Grafické algoritmy.

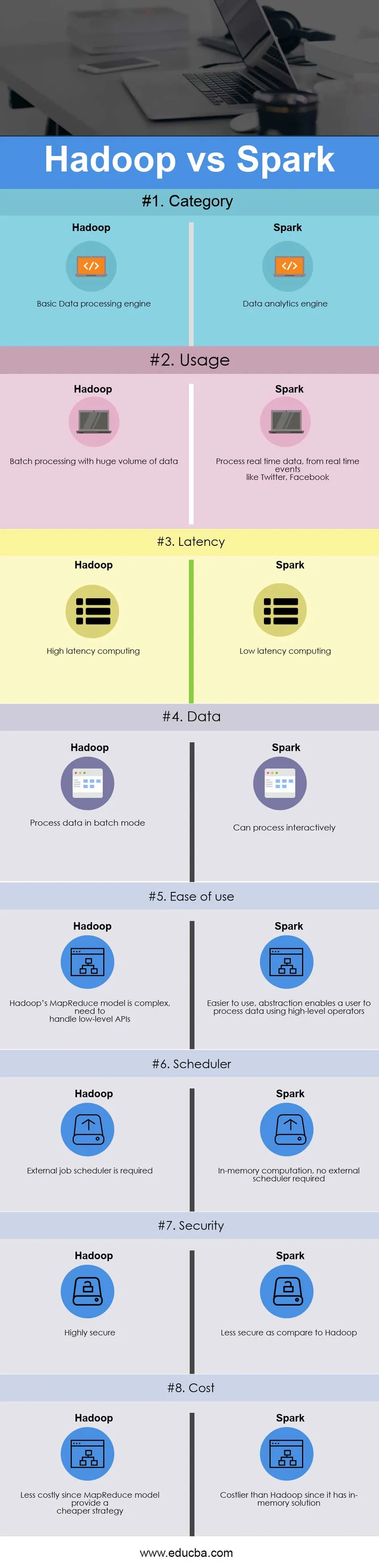

Srovnání hlava-hlava mezi Hadoopem a Sparkem (infografika)

Níže je osm nejlepších rozdílů mezi Hadoopem a Sparkem

Klíčové rozdíly mezi Hadoopem a Sparkem

Oba Hadoop vs Spark jsou populární volby na trhu; pojďme diskutovat o některých hlavních rozdílech mezi Hadoopem a Sparkem:

- Hadoop je framework s otevřeným zdrojovým kódem, který používá algoritmus MapReduce, zatímco Spark je technologie bleskové klastrové výpočetní techniky, která rozšiřuje model MapReduce tak, aby jej bylo možné efektivně používat s více typy výpočtů.

- Model Hadoop MapReduce čte a zapisuje z disku, čímž zpomaluje rychlost zpracování, zatímco Spark snižuje počet cyklů čtení / zápisu na disk a ukládá mezipaměť do paměti, a tedy rychlejší zpracování.

- Hadoop vyžaduje, aby vývojáři předali každou operaci kód, zatímco Spark lze snadno programovat pomocí RDD - Resilient Distributed Dataset.

- Model Hadoop MapReduce poskytuje dávkový motor, a proto závisí na různých motorech pro další požadavky, zatímco Spark provádí dávkové, interaktivní, strojové učení a streamování vše ve stejném klastru.

- Hadoop je navržen pro efektivní zpracování dávkového zpracování, zatímco Spark je navržen pro efektivní zpracování dat v reálném čase.

- Hadoop je výpočetní systém s vysokou latencí, který nemá interaktivní režim, zatímco Spark je výpočetní systém s nízkou latencí a může interaktivně zpracovávat data.

- S Hadoop MapReduce může vývojář zpracovávat data pouze v dávkovém režimu, zatímco Spark může zpracovávat data v reálném čase prostřednictvím Spark Streamingu.

- Hadoop je navržen tak, aby zvládal chyby a poruchy, je přirozeně odolný vůči poruchám, a proto je vysoce odolný vůči systémům, zatímco díky systému Spark umožňuje RDD obnovení oddílů na selhaných uzlech.

- Hadoop potřebuje například externí plánovač úloh - Oozie, aby naplánoval složité toky, zatímco Spark má výpočet v paměti, takže má svůj vlastní plánovač toku.

- Hadoop je levnější varianta, která je k dispozici, zatímco je porovnává z hlediska nákladů, zatímco Spark vyžaduje hodně paměti RAM pro spuštění v paměti, čímž se zvyšuje cluster a tím i náklady.

Srovnávací tabulka Hadoop vs Spark

Primární srovnání mezi Hadoopem a Sparkem je popsáno níže

| Základ srovnání Hadoop vs Spark |

Hadoop |

Jiskra |

| Kategorie | Základní modul pro zpracování dat | Nástroj pro analýzu dat |

| Používání | Dávkové zpracování s obrovským objemem dat | Zpracovávejte data v reálném čase z událostí v reálném čase, jako jsou Twitter, Facebook |

| Latence | Výpočty s vysokou latencí | Výpočet s nízkou latencí |

| Data | Zpracování dat v dávkovém režimu | Může zpracovávat interaktivně |

| Snadnost použití | Hadoopův MapReduce model je složitý, musí pracovat s nízkoúrovňovými API | Díky snadnějšímu použití abstrakce umožňuje uživateli zpracovávat data pomocí operátorů na vysoké úrovni |

| Plánovač | Je vyžadován externí plánovač úloh | Výpočet v paměti nevyžaduje žádný externí plánovač |

| Bezpečnostní | Vysoce bezpečné | Méně bezpečné ve srovnání s Hadoopem |

| Náklady | Levnější, protože model MapReduce poskytuje levnější strategii | Nákladnější než Hadoop, protože má řešení v paměti |

Závěr - Hadoop vs Spark

Hadoop MapReduce umožňuje paralelní zpracování velkého množství dat. Rozděluje velký kus na menší, které se zpracovávají samostatně na různých datových uzlech, a automaticky shromažďuje výsledky přes více uzlů, aby vrátil jediný výsledek. V případě, že výsledný datový soubor je větší než dostupná RAM, může Hadoop MapReduce překonat Spark.

Na druhé straně je Spark snadnější než Hadoop, protože přichází s uživatelsky přívětivými API pro Scala (jeho rodný jazyk), Java, Python a Spark SQL. Protože Spark poskytuje způsob, jak provádět streaming, dávkové zpracování a strojové učení ve stejném klastru, je pro uživatele snadné zjednodušit svou infrastrukturu pro zpracování dat.

Konečné rozhodnutí vybrat mezi Hadoop vs Spark závisí na základním parametru - požadavku. Apache Spark je mnohem vyspělejší klastrový výpočetní stroj než Hadoop's MapReduce, protože zvládne jakýkoli typ požadavku, tj. Dávkové, interaktivní, iterativní, streamování atd., Zatímco Hadoop omezuje pouze dávkové zpracování. Současně je Spark nákladnější než Hadoop s funkcí paměti, která nakonec vyžaduje hodně paměti RAM. Na konci dne to vše záleží na obchodním rozpočtu a funkčním požadavku. Doufám, že teď musíte mít spravedlivější představu o obou Hadoop vs Spark.

Doporučený článek

Toto byl průvodce největším rozdílem mezi Hadoopem a Sparkem. Zde diskutujeme také klíčové rozdíly Hadoop vs Spark s infografikou a srovnávací tabulkou. Další informace naleznete také v následujících článcích Hadoop vs Spark.

- Datový sklad vs Hadoop

- Splunk vs Spark

- Hadoop vs Cassandra - 17 úžasných rozdílů

- Prase vs Spark - který je lepší

- Hadoop vs. výkon SQL: rozdíl